ord=1,为啥不是求和,能帮忙解答下吗

其实也不是不可以相处,广播机制先开始是先将两个张量的维度先右对齐,右对齐之后短的张量存在的维度除1之外必须和长的长量的维度相同否则不能广播,例如维度为(2,3,4)和(4)的就可以广播,而(2,3,4)和(5)就不能广播因为右对齐之后发现4和5不相等,而作业上的这道题torch.Size([5, 4]), torch.Size([5])右对齐之后发现5不等于4所以不能广播,加上A/A.sum(axis=1, keepdims=True),维度变为torch.Size([5, 4]), torch.Size([5,1])右对齐后1与4对应,因为1可以广播到4所以两个运算正确

其实也不是不可以相处,广播机制先开始是先将两个张量的维度先右对齐,右对齐之后短的张量存在的维度除1之外必须和长的长量的维度相同否则不能广播,例如维度为(2,3,4)和(4)的就可以广播,而(2,3,4)和(5)就不能广播因为右对齐之后发现4和5不相等,而作业上的这道题torch.Size([5, 4]), torch.Size([5])右对齐之后发现5不等于4所以不能广播,加上A/A.sum(axis=1, keepdims=True),维度变为torch.Size([5, 4]), torch.Size([5,1])右对齐后1与4对应,因为1可以广播到4所以两个运算正确·······

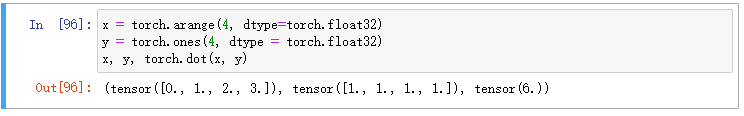

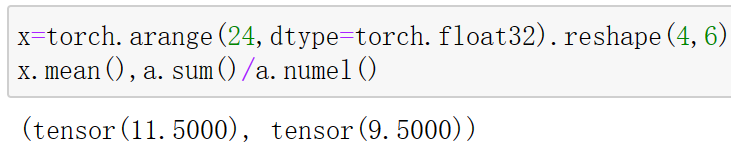

运算的结果是一致的,你上面写的是x.sum()/x.numel(),这里的a是哪里来的呢?

A @ B好像并不少见,而且一开始是由numpy最先使用的 A @ B,到后面python解释器版本,直接把这个用法内置了,也就是不用引入numpy,也可以直接使用 A @ B

A @ B好像并不少见,而且一开始是由numpy最先使用的 A @ B,到后面python解释器版本,直接把这个用法内置了,也就是不用引入numpy,也可以直接使用 A @ B

axis是轴序号,按轴来理解比较好。降维实际上是选择一个轴,把这个轴给去掉,去掉的同时可以使用平均、求和等操作保留信息。自己扩展到3个轴,4个轴,看下sum、mean的行为是怎么样的就好理解了。

你是分别求的x的平均值和a的平均值,x和a是不是相等的?不等的话平均值不一样也很正常啊 。

可以这样理解,不如将 axis=?看作是从前开始数的第(?+1)个[ ,这样看上去更清晰一点,高维张量也是一样

axis=0 书上写对所有行操作,省去了一个前置:(对一列的)所有行进行操作。语文翻译引起了歧义

你好,请问是哪一个第7题?2.3线代这章好像没看到曼哈顿距离相关的题

-

证明一个矩阵𝐴的转置的转置是𝐴,即(𝐴⊤)⊤=𝐴。

相当于绕对角线旋转360度 -

给出两个矩阵𝐴和𝐵,证明“它们转置的和”等于“它们和的转置”,即𝐴⊤+𝐵⊤=(𝐴+𝐵)⊤。

因为Aij = ATji , Bij = BTji

所以ATji + BTji = Aji + Bji

(A+B)ij = Aij + Bij

(A+B)Tji = (A+B)ij = Aij + Bij = ATji + BTji -

给定任意方阵𝐴,𝐴+𝐴⊤总是对称的吗?为什么?

即证明(A+AT)T = A+AT

因为2 , (A+AT)T = AT + (AT)T

因为1 , (AT)T=A

所以(A+AT)T = AT + A = A + AT -

本节中定义了形状(2,3,4)的张量

X。len(X)的输出结果是什么?

2,len(X)返回第一个dimention长度. -

对于任意形状的张量

X,len(X)是否总是对应于X特定轴的长度?这个轴是什么?

第一个dimention的维数 -

运行

A/A.sum(axis=1),看看会发生什么。请分析一下原因?

假如A = shape(4,3) , 那么 A.sum(axis=1).shape 是(4,), A/A.sum(axis=1) 报错,因为其最后一个dimention 4 不是1 ,无法完成广播.

假如A = shape(2,3,4),那么A.sum(axis=1).shape是(2,4),与(2,3,4)之间无法完成广播, 也是报错

假如A = shape(2,2,4),那么A.sum(axis=1).shape是(2,4),与(2,2,4)之间可以完成广播.但是这个除法的语义不对 -

考虑一个具有形状(2,3,4)的张量,在轴0、1、2上的求和输出是什么形状?

分别是(3,4),(2,4),(2,3) -

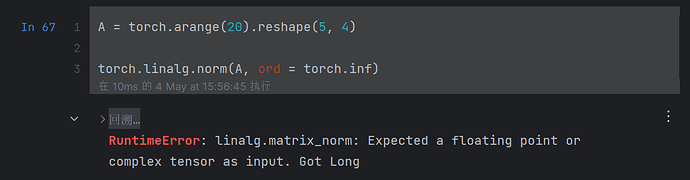

为

linalg.norm函数提供3个或更多轴的张量,并观察其输出。对于任意形状的张量这个函数计算得到什么?

torch.linalg.norm(torch.arange(20,dtype=torch.float32)) => 49.6991

torch.linalg.norm(torch.arange(20,dtype=torch.float32).reshape(5,2,2)) => 49.6991

不论shape, 都是得到所有元素的$\sqrt {\Sigma X^2}$

https://zh.d2l.ai/chapter_preliminaries/linear-algebra.html#id10

“ 我们可以把一个矩阵𝐴∈𝑅𝑚×𝑛乘法看作一个从𝑅𝑛到𝑅𝑚向量的转换”表述成

“把向量𝑥∈𝑅𝑛乘以𝐴∈𝑅𝑚×𝑛看作𝑥从𝑅𝑛到𝑅𝑚向量的转换”可能会更明了一些。

第2题的证明缜密点应该是设C=A + B,A、B、C的转置分别是D、E、F,那么有:

fji = cij = aij + bij = dji + eji

得证

- 对于轴或维,NumPy 中使用

axis,PyTorch 中使用dim; - 对于维度保持,NumPy 中使用

keepdims,PyTorch 中使用keepdim。

虽然它们在运行时是兼容的,但为了在 PyCharm 等 IDE 中有更好的代码提示体验,应规范这些参数的使用。

更具体地,是将目标函数(这里是 sum())作用在的维度 dim=0 上。目标函数恰巧可以实现降维。