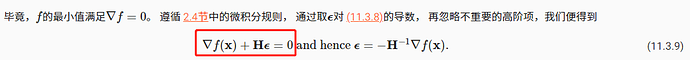

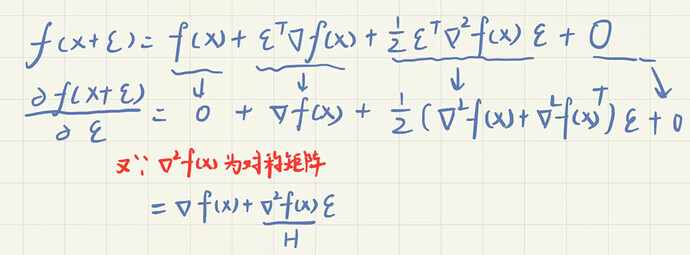

我理解为11.3.8式子,就是上式对符号ε求导

这里写的不好, 其实应该是g(ε) = f(x+ε); 则g(ε) - g(0) = f(x+ε) - f(x) = 展开的那一串. 此时若f(x+ε)达到了极小值点, 即g(ε) 达到了极小值点, (# 注意!!! 我们此时ε才是变量, x是常量), 对ε求导, 就可以得到后面的式子了.

1 Like

这里面有个问题, 就是凸优化中没有规定何为"恒定"收敛速度, 在文中给出的例子, 牛顿法是二阶收敛的, 一般只有线性, 超线性, 次线性以及r阶收敛, 没有听说过恒定收敛这个词.

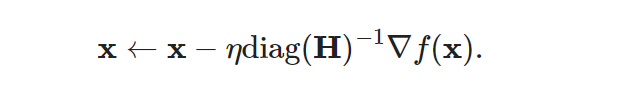

在预处理中,

这个公式是如何做到为每个变量选择不同的学习率的?

这一节都没什么评论是不是很多人都看不懂。。我也是。。有没有数学大神出来完整解释一下