是除了batchsize。默认从第一个维度开始把后面的都展平,包括多个通道的也展平

卷积层计算次数:

加法:(参数量-1)输出层规模

乘法:参数量输出层规模

理由:假设卷积层有n个参数,则每个参数都要与输入层中的元素相乘,得到n个结果,再将n个结果相加,得到每个输出元素的值,一共要进行n次乘法,和n-1次加法

全连接层计算次数:

加法=乘法=参数量

理由:参数规模为[c_i,c_o],每列参数与输入向量相乘再加上bias,得到一个输出值,进行c_i次乘法,c_i次加法,则要生成c_o个输出值,则共需要进行c_i*c_o次加法/乘法运算

具体改哪里怎么改让它指向本地呢,请教一下

进行手算了,加了这个padding是错的,得到的结果不是整数

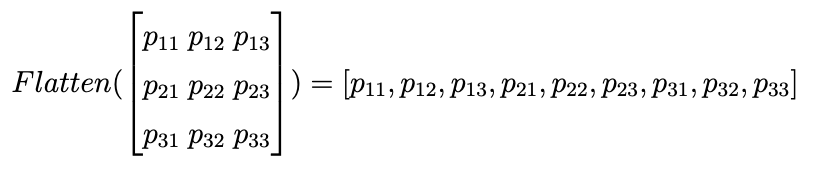

展平层 Flatten() 的默认值start_dim=1, end_dim=-1,表示dim=0(也就是shape[0])保留,而后面的维度的维数(dimensionality)相乘,因此:

假设输入 X 是一个形状为 (batch_size, channels, height, width) 的四维张量,

输出就是(batch_size, channels×height×width)的二维张量。

我在colab上可以跑啊,google好像给了块GPU

在windows环境下运行本书中的很多例子,如果出现Runtime error: DataLoader worker exited unexpectedly. ,这主要是由于d2l torch.py中的get_dataloader_workers()返回4。windows下多进程执行DataLoader 容易出错。解决方法是get_dataloader_workers()返回0,如下:

def get_dataloader_workers():

“”"Use 4 processes to read the data. 0 process for windows.

Defined in :numref:`sec_fashion_mnist`"""

return 0 if sys.platform.startswith('win') else 4

应该是pad=(2,1)才能算出来输出高宽为54*54吧

我尝试把dropout修改成0.6,准确率上升很多,但是在训练50个epoch后,出现过拟合倾向。

[quote=“BLBBB, post:43, topic:1863”]

nn.Linear(4096

[/q960203uote]