https://zh.d2l.ai/chapter_linear-networks/linear-regression.html

在 (3.1.3) 中,向量 𝐱x 对应于单个数据样本的特征。用符号表示的矩阵 𝐗∈ℝ𝑛×𝑑X∈Rn×d 可以很方便地引用我们整个数据集的 𝑛n 个样本。其中,𝐗X 的每一行是一个样本,每一列是一种特征

这段话中对于每一行的描述是不是不太妥当?我认为每一行是没有什么实际意义的,如果每一列是一个样本的全部特征,那么每一行只是表示所有样本的第一个特征的集合,我想你们想表达的是行列所代表的意义,我认为更妥当的说法是“行数代表了一个样本的特征数量,而列数代表了样本数”

说每一行是一个样本,每一列是一种特征没啥问题吧,矩阵X的size是n行d列,就是说数据集有n个样本,每个样本有d个特征,所以用你的说法来说就是行数代表了样本数,列数代表了特征数量。

我看你表达的和作者明明是同一个意思啊,只是表达方式不一样而已。

李老师这本书写得实在是太好了,解释的非常清楚,非常明白,堪称机器学习中的一绝级别的作品,机器学习中的僻邪剑谱。

你好,请问有每一节课后练习的参考答案吗?做完练习以后不太清楚自己答案的正确性。

第 3 小题不太会做,希望得到大家的帮助和指点,谢谢了。

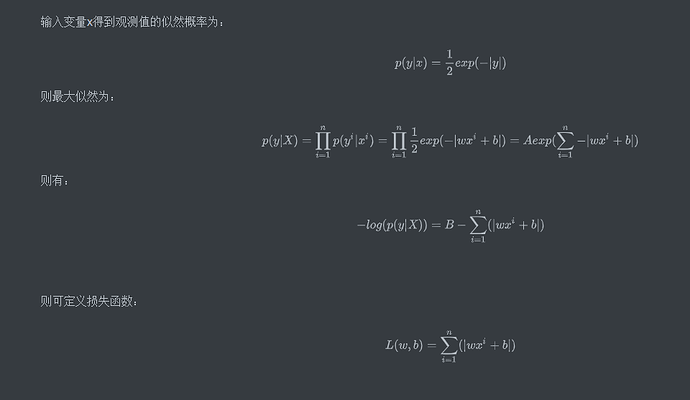

尝试解答:

- -\log P(y|X)=1/2\sum_i|y^{(i)}-w^T x^{(i)}-b|

- 对比 3.1 小节案例,最小化第 1 问结果的损失函数是(省略偏差 b) $loss=\sum_i|y^{(i)}-w^T x^{(i)}|$,也就是 MAE 。与之对比,3.1小节案例中的损失函数是 MSE。解析解是什么?我没有求出来。

- 因为MAE导数不连续,驻点处不可导,梯度下降法可能碰到问题。解决办法是采用 Huber loss,即当损失函数小于一定阈值后,就用MSE 代替 MAE。

同求…

谁可以讲解下3.1.8的求导过程吗,不是太清楚

你可以去csdn上 搜索: 线性回归系数,局部加权线性回归系数的数学推导

Q3.3 最终得到的损失函数是L1-loss(MAE)的形式,即y=|x|。这一函数在零点不可导,并且导数的绝对值恒为1,这意味着loss很小(接近驻点)时依然可以产生很大的梯度,导致参数剧烈波动难以收敛。一般可以采用smooth L1-loss代替L1-loss,取得更稳定的收敛结果

请问式3.1.12怎么推导出来式3.1.13的?

我是这么理解的:预测值和真实值的差服从标准高斯分布,因此在输入x的前提下预测为y的概率p(y|x)服从e的分布

记录一下做题

1.1:最优就是数据集的均值,我是展开求导得到的

1.2:感觉是个开放题?如果x1…xn原本就是正太分布的话,在除以方差就可以标准化。

2.1-.2.3:XW=Y.因为是平方根误差,问题转化为最小化:0.5(y-XW)**2。令其导数等于0,然后根据矩阵的倒数和变化可以得到解析解:w=(X⊤X)−1X⊤y.

2.4是什么意思呢?没有搞懂

3.1 -log(exp-(|y(i)-w(t)x(i)|))

3.2解析解就是最小化|y(i)-w(T)x(i)|。令绝对值里面为0即可

3.3,这个绝对值损失函数在最小值处不可导。。解决方法参考了上面同学的回答比如SMOOTH-L1损失函数什么的。

不知道思路有没有问题,恳请大家指正

Section 3.1.1.3里有这一句话:“首先,我们将偏置 b 合并到参数 w 中。合并方法是在包含所有参数的矩阵中附加一列。”

我没法想象这个步骤完成后的参数w的矩阵是什么样的。请问有大佬知道吗?

关于2.3,可以用正规方程解释.

2.4 沐神提到,只有像线性回归这种极少数情况有解析解,优点是可以达到理论的最值。sgd适用范围更大,但是在有限步内只能趋近最值。

每小节课后练习有些不会做,想知道哪里能看到答案?

难道课后练习没有答案吗?不会的要在讨论区询问吗?

朋友,你好,麻烦问一下,你找到课后习题的答案了吗?我做完题,也想核对一下。不然心里没谱。