对咱俩的答案一样,没问题?这个还有20的限制吗

3.4.7建议解释下,看的一脸懵逼,下面的回复解释的也不太清晰

这一节分类标签,(鸡,猫,狗),上下文不一致。

请问“课后联系”的代码在哪里可以下载?或者文档也可以

这部分不少人读不懂,感觉不是很通透,希望解答下

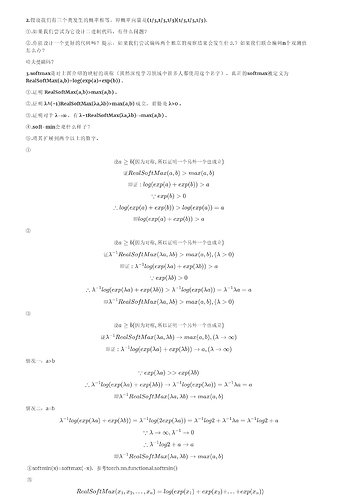

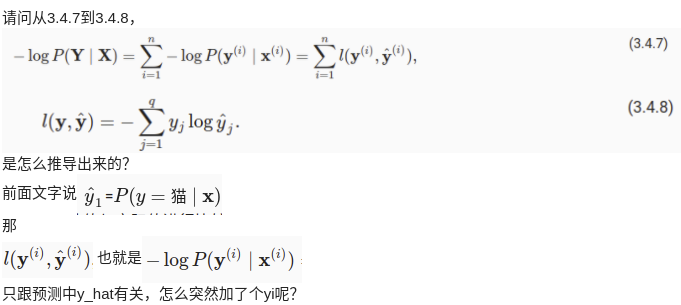

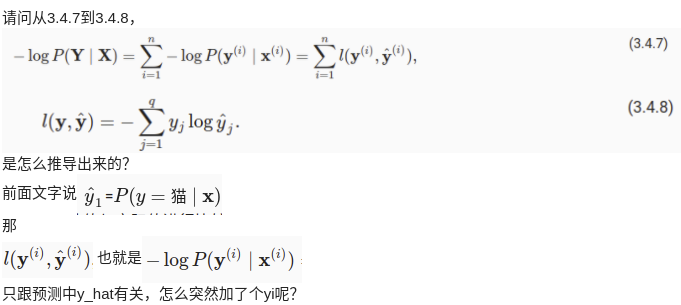

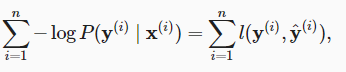

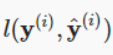

好棒!懂了。不过3.4.7中,请问为何 直接就相等了呀。不理解

直接就相等了呀。不理解

这是一种简略的写法,实际上是新定义了一个函数,也就是 ,使其等于

,使其等于![]()

请问我应该如何发“PR”呢?页面上好像没有找到这个选项,谢谢!

应该在github的界面上发,这里是没有的

###########################################################################

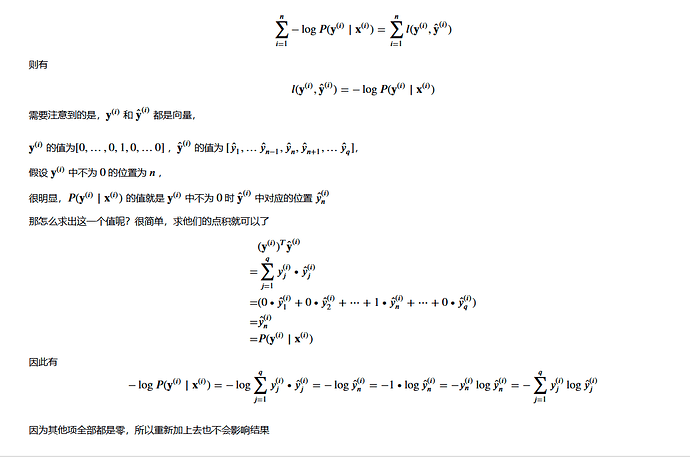

3.4.9公式的第二行到第三行中,为什么yj的求和在第一项中去掉了,在第二项中保存下来了?????

第一项后面是k,所以可以直接加了,加起来是1,所以省略

能否用神经网络去拟合pytorch中内置的损失函数BCELOSS,如果能网络结构应该是怎么样的》?

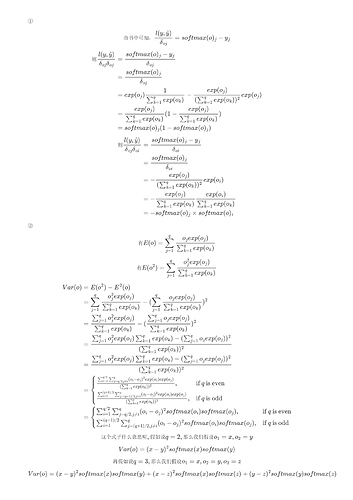

请问3.4.6.2损失函数求梯度为什么是对o_j求导,而不是对参数求导呢?

3.4.7到3.4.8的推导:输入[x1, x2, …, xd]到网络中得到输出[y’1, y’2, …, y’q],注意这里的每个输出y^i都是已经使用softmax归一化的概率。这时我们样本的标签对应为[0, 0, …, 1, …],就假设第i类为1好了,即yi=1,那么这时 p(y=i | X) = y’i。那么我们如何写成一个一般化的式子表示p(y=i | X)的概率呢?不妨这样表示 p(y = i | X) = (y’1 * y1) * (y’2 * y2) * … (y’i * yi) …(y’q * yq)。这样的话我们就可以得出极大似然估计的表达式了,即3.4.7 和 3.4.8。(‾◡◝)

AttributeError: module ‘torch’ has no attribute ‘synthetic_data’

AttributeError: module ‘torch’ has no attribute ‘set_figsize’

我在运行代码时出现这样报错有大佬可以帮我解析一下吗?抱歉我是个编程小白